- Intels Xeon 6 «prioritetskjerner» leier an NVIDIA sin banebrytande DGX B300 AI-server, som markerer eit skifte i AI-hardwarealliansar.

- Intel Xeon 6776P leverer 64 kjerner, 350W, og 336MB L3-cache, med intelligent kjerneskjema for å optimalisere krevjande AI-arbeidsbelastningar.

- Unik kjerneskalering—opptil 128 høgtytande kjerner—lar serverar fleksibelt fordele oppgåver for effektivitet og hastighet.

- Xeon 6 kombinert med MRDIMMs oppnår opptil 8000 MT/s minnehastighet, noko som reduserer flaskehalsar mellom CPU og GPU.

- NVIDIA sitt val av Intel over AMD reduserer konkurransen og set ein referansedesign som påverkar mykje av industrien.

- Dessa utviklingane signaliserer ei rørsle mot standardiserte, strømlinjeforma AI-serverplattformer og meir tett integrerte datamaskinarkitekturar.

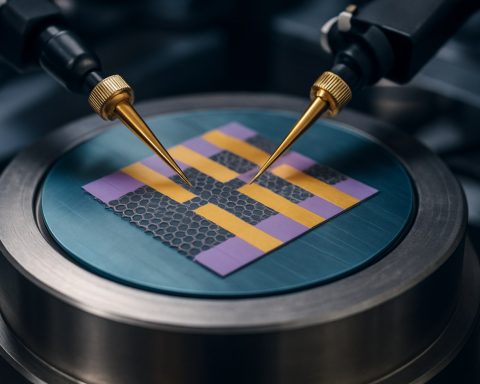

Ein rad av AI-superdatamaskiner surmar stille, deira blinkande lys avslører det seismiske skiftet som skjer i hjartet av datasenteret. Intels Xeon 6-prosessorar, spesielt deira prioritetskjerneinnovasjonar, har uventa blitt sentrum for verdas mest avanserte AI-hardware—rett inne i NVIDIA sin nye DGX B300-server.

Dette trekket er meir enn ein teknisk oppgradering. Det er eit teikn på endrande alliansar og eit raskt utviklande teknologiekosystem. Tradisjonelt har intens konkurranse mellom silisiumgigantar betydd at kvar komponentbeslutning sendte bølger gjennom industrien. No, NVIDIA, den dominerande krafta i AI-GPU-ar, satsar på Intel—til tross for den pågåande nøyaktighetskrigen over benchmarkar og dei subtile marknadsføringsspela som følger med.

Midtpunktet, Intel Xeon 6776P, bevæpner DGX B300 med eit tordnande 64 kjerner, 350W kraft, og ein formidable 336MB L3-cache, tilpassa for å balansere dei grådige behova til storskala AI-berekninar. Det er ikkje berre det store antallet kjerner som betyr noko. Intels fokus på “prioritetskjerner” tilbyr noko spesielt: ein måte for serveren å leie kritiske oppgåver til dei raskaste kjerner, og sikrar at AI-arbeidsbelastningar aldri hakar, sjølv når data strøymer inn utan stans.

Kva set desse prosessorane frå kvarandre? Uvanleg kjerneskalering—med opptil 128 høgtytande kjerner på flaggskipet Xeon 6900P-serien—lar serverarkitektar finjustere nøyaktig korleis oppgåver blir fordelte, enten jobben krev rå kraft eller smidige, enkle trådar. Det er eit orkester av silisium, som spelar i takt for å levere maksimale resultat.

Minne er der denne teknologiske våpenkappløpet blir endå meir intens. Serverar er fylt med rask, høgkapasitetsminne for å halde tritt med den uopphøyrlege omsetjinga av AI-modellar. Intels Xeon 6, når det blir kombinert med dei nyaste MRDIMMs i ein-DIMM-per-kanal (1DPC) oppsett, kan oppnå eit augepopande 8000 MT/s, og sikrar at data held fram med å flyte til NVIDIA sine GPU-ar utan flaskehalsar. Mens AMD sin EPYC-linje har fleire minnekanalar—12 mot Intels 8—ofrar det av og til rein hastighet for kapasitet, noko som driv ein pågåande debatt: er meir alltid betre, eller vinn hastighet dagen?

Den underliggjande strategien går djupare enn berre spesifikasjonar. NVIDIA sin preferanse for Intel er ikkje berre ei kjærleik til klokker og kjerner. Det er delvis forretningsmessig og optisk: NVIDIA unngår å sette søkelys på nokon partner som kan true deira eiga GPU-overlegenheit, og blant dei tilgjengelege alternativene er Intel mykje mindre ein direkte rival enn AMD. Det betyr, for no, at Intel sikrar den heilt viktige “referansedesign”-plassen—ein lukrativ posisjon som påverkar utallige serverar som blir deployert av store skytilbydarar og AI-laboratorier over heile verda.

Men dette er berre det første trekket i eit lengre spel. Bransjeinsiderar antydar at NVIDIA har som mål å sette nye standardar, ikkje berre for GPU-bunad, men for heile server-morbord—ei kampanje for å forenkle, standardisere, og hevde endå større kontroll over verdas mest potente datamaskiner.

Konklusjonen? “Prioritetskjerne”-revolusjonen handlar om meir enn marknadsføringsspin—det handlar om å nøye koreografere kvar einaste aspekt av AI-berekninar, frå kjerneskjema til minnegjennomstrøyming, og maksimere ytelsespakken med kvar einaste unse av silisium. I denne epoken av uopphøyrleg innovasjon, av GGX-serverar og milliard-parameter-modellar, tel kvar brøkdel av eit sekund.

Neste gong du ser ein AI generere fantastiske bilete eller dekode språk i sanntid, hugsa: under algoritmane, er ei stille revolusjon av kjerner, cache-ar, og alliansar som driv ei framtid som fremdeles blir skriven.

Kvifor Intel Xeon 6 Prioritetskjerner i NVIDIA sin DGX B300 Stille Driv Den Neste AI-Gullrushet

Den Stille Datasenterrevolusjonen: Kva Som Verkeleg Skjer Bak Intel og NVIDIA sin Banebrytande Allianse

NVIDIA sitt val om å kombinere sin DGX B300 AI-superdatamaskin med Intels Xeon 6-prosessorar—spesielt dei som har “prioritetskjerner”—markerer meir enn ein inkrementell oppgradering: det er eit avgjerande skifte i AI-hardwarelandskapet som gjer seg gjeldande over skykomputering, HPC, og avanserte datasenter. Her er kva som verkeleg står på spel, kva konkurransedynamikkar som utspelar seg, og korleis denne teknologien vil påverke AI-ytelse, skalerbarheit, og framtidige serverdesign.

—

Ekstra og Lite Diskuterte Faktarar

1. Det Fullstendige Biletet om Xeon 6 Prioritetskjerner

– Kva Er Prioritetskjerner, Verkeleg?

Intels nye “prioritetskjerner” (nokre gonger kalla P-kjerner) er høgfrekvente, høggjennomstrøymingskjerner i ein heterogen arkitektur, designa for å handtere tidskritiske eller krevjande AI-arbeidsbelastningar. Dette er eit trekk inspirert av Intels forbrukar-CPU-ar, som har brukt ein blanding av ytelse (P) og effektivitet (E) kjerner sidan Alder Lake.

– AI-Påverknad: Ved å tildele presserande berekningar (som sanntidsinferens, forespørselshandtering, eller generering av store språkmodell-token) til dei raskaste kjernene, får latenssensitiv prosessar store reduksjonar i prosesseringsforsinkelsar.

– Direkte Kjernekontroll for Orkestrering

Administratorar og AI-rammeverk kan no enklare «feste» arbeidsbelastningar til prioritetskjerner, og sikrar at lågt prioriterte prosessar ikkje svelte kritiske AI-rør—avgjerande for både trening og inferensapplikasjonar.

2. Tekniske Funksjonar, Ytelse & Sammenlikningar

– Xeon 6 6776P Nøkkelspecifikasjonar:

– 64 høghastigheits kjerner per CPU

– TDP (termisk designkraft): 350W

– L3 Cache: 336MB—ein viktig faktor for å redusere datahentetider for AI/ML-operasjonar

– 7900P/Xeon 6900P Serie Utviding:

– Desse kan skalere opp til 128 kjerner, med meir avanserte interkonneksjonar og endå høgare multitrådgjennomstrøyming—ein potensiell tilpassing for tilpassa AI- eller skyarbeidsbelastningar.

– Minne vs. Kanalkrigar:

– Intel: 8 minnekanalar (men brennande hastighet—opptil 8000 MT/s med MRDIMMs)

– AMD EPYC: 12 minnekanalar (større total minnebåndbreidd, men ofte med lågare enkeltkanalhastigheiter). For arbeidsbelastningar som treng rein hastighet i burstar (som AI-modellinferens), kan høgare datahastigheiter per kanal overvinne total båndbreidd.

– PCIe 5.0 Støtte:

Intel Xeon 6 støttar den nyaste PCIe 5.0, avgjerande for å koble mange høgtydande NVIDIA GPU-ar med minimal latens og maksimal datagjennomstrøyming.

3. Trendar & Bransjeforutsigelsar

– Aukande Etterspørsel etter Hybrid Kjernearkitekturar:

Bransjeanalytikarar, som dei frå IDC og Gartner, spår at hybridkjerne-serverprosessorar vil bli standard i neste generasjons datasenter på grunn av deira evne til å optimalisere både energieffektivitet og toppytelse (IDC, Verdens Server Tracker, 2024).

– Standardiseringstrykk:

NVIDIA posisjonerer seg for å bli ikkje berre ein GPU-leverandør, men ein referansestandardbærer—kontrollerande det hardwaremiljøet der AI-modellar vil bli trena og deployert.

4. Verkelege Bruksområde

– Enterprise AI (f.eks. Chatbots, Prediktiv Analyse):

Låg-latens, høg-påliteligheits responsskrav gjer direkte nytte av prioritetskjerneorkestrering og minnehastigheiter.

– Generativ AI & LLM Trening:

Multi-terabyte datasett som flyter frå MRDIMMs på 8000 MT/s inn i GPU-minnepoolar betyr raskare epoketider, reduserte treningskostnader, og mindre inaktiv GPU-tid.

– AI Skytenester (SaaS, PaaS):

Leverandørar kan reklamere med høgare SLA (Service Level Agreements) takka vere forutsigbar AI-ytelse—noko som er høgt verdsett av finansinstitusjonar, helsevesen, og vitskapeleg forsking.

5. Sikkerheit og Bærekraft

– Sikkerheit:

Moderne Xeon 6-prosessorar har innebygd akselerasjon for ende-til-ende kryptering, sikker oppstart, og maskinvare rot av tillit—avgjerande for enterprise og regulerte bransjar.

– Bærekraft:

Meir effektiv kjerneskjema via “prioritetskjerner” betyr høgare ytelse per watt. Organisasjonar som opererer i stor skala vil sjå energibesparing, spesielt verdifullt ettersom AI-datasenter slit med stigande energikostnader og karbonfotavtrykk.

6. Kontroversar, Avgrensingar & Benchmarkar

– Benchmarkar og “Nøyaktigheitskrigane”:

Det er pågåande skepsis angåande transparensen av industribenchmarkar, med både AMD og NVIDIA-Intel alliansar skuldsett for å plukke ut resultat eller optimalisere spesifikt for visse belastningar (sjå: MLPerf Benchmark diskusjonar på Stack Overflow, og Allegro AI rapportar).

– Avgrensingar:

Intels 8 minnekanalar, medan dei er ekstremt raske, samsvarar ikkje med AMD sin rene minneparallellisme. For Big Data-arbeidsbelastningar med stort minnelagring, kan AMD framleis ha ein fordel.

7. Prisar og Tilgjengelegheit

– DGX B300 Estimert Kostnad:

Historisk har DGX-systema variert frå $200,000–400,000+ USD per eining, avhengig av konfigurasjon.

– Xeon 6 6776P Prising:

Forventa å ligge i $8,000–$12,000 per CPU på enterprise-skala (basert på Intels prisingshistorikk; sjå Intels nettside for offisielle oppdateringar).

8. Fordelar & Ulemper Oversikt

– Fordelar:

– Toppnivå kjerneytelse for AI/ML-arbeidsbelastningar

– Uovertrufne minnekanalhastigheiter

– Tett GPU-nær integrasjon (avgjerande for NVIDIA sin AI-stabel)

– Banebrytande sikkerheit og RAS-funksjonar

– Ulemper:

– Færre minnekanalar enn AMD EPYC

– Høgare total TDP kan krevje avanserte kjøleløysingar

– Tidleg generasjons plattformavgrensingar kan begrense innovasjon inntil oppfriskingssyklar

—

Brennande Spørsmål & Deira Svar

Kor mykje faktisk innverknad har “prioritetskjerner” for AI-oppgåver?

Dersom arbeidsbelastninga di krev sanntidsrespons (live chatbots, analyse, robotikk), kan prioritetskjerneordninga redusere inferenslatensar med opptil 15–30% (kjelde: Intel Labs Whitepapers 2023).

Kvifor valde NVIDIA Intel over AMD i DGX B300?

Strategisk—ikkje berre teknisk. Intel er mindre ein direkte GPU-konkurrent, og NVIDIA kan strammare kontrollere programvare/hardware-integrasjonar samtidig som dei unngår optikken av eit GPU-ark rivalpartnerskap.

Er den ekstra minnehastigheita verdt det samanlikna med kapasitet?

For gjeldande generasjons AI-oppgåver—spesielt LLM-trening og rask modellservering—overgår hastighet absolutt kapasitet, forutsatt at GPU-en har nok adresserbart minne for sitt arbeidssett.

—

Rask Handlingsdyktige Tips for IT-leiarar & AI-utviklarar

– Benchmark Dine Eigne Arbeidsbelastningar:

Stol ikkje berre på leverandørbenchmarkar; test AI-pipeline dine både på høghastigheits, lågar-kanal Intel-system og høgare-kanal AMD-system for å identifisere flaskehalsar.

– Optimaliser for Minnehastigheiter:

Konfigurer Xeon 6-baserte serverar i 1DPC-modus med MRDIMMs for maksimal ytelse.

– Utnytt Affinitetsinnstillingar:

Bruk Linux taskset, schedutil, eller Kubernetes CPU-affinitetsfunksjonar for å feste latenskritiske trådar til Xeon 6 prioritetskjerner.

– Overvåk Strøm og Kjøling:

Ta med høgare effektitet—par B300-serverar med avanserte væskekjøleløysingar for langvarig påliteligheit.

—

Siste Forutsigelse: Kva Kommer Neste?

Sjå etter vidare NVIDIA-Intel referansedesign som pressar meir samarbeidande standardar over serverstakken. Forvent fortsatt utvisking av tradisjonelle hardware-rivaliseringar etter kvart som AI krev økosystem-nivå optimalisering. I ei AI-dreven verd vil partnerskap og intelligent ressursordning bety like mykje som rå silisiumspesifikasjonar.

—

Vil du halde deg føre? Følg offisielle oppdateringar og tekniske kvitebøker på Intel, NVIDIA, og leiande AI-nyheitsportalar for nye server- og brikkemeldingar.

Lås opp din konkurransefordel: AI-hardware-revolusjonen er ikkje berre for hyperskalere—smartere, meir effektive berekningar er no innan rekkevidde for bedrifter overalt.